如何使用爬虫获取信息 (如何使用爬虫代理服务器提高数据收集效)

在当今信息化的时代,获取大量的数据对于许多企业和研究机构来说至关重要。而使用爬虫技术可以帮助我们高效地从互联网上收集所需的信息。然而,由于互联网上的一些限制和反爬虫措施,我们可能会面临一些挑战。在本文中,我们将介绍如何使用爬虫代理服务器来提高数据收集效率。

首先,让我们简要了解一下什么是爬虫。爬虫是一种自动化程序,可以模拟人类的浏览行为来收集互联网上的信息。它可以通过发送HTTP请求、解析HTML页面和提取所需的数据来实现这一目标。然而,由于访问过于频繁或者IP地址被封锁等原因,我们可能无法正常使用爬虫来获取所需的数据。p

这就是为什么我们需要使用爬虫代理服务器。爬虫代理服务器充当了一个中间人的角色,它可以隐藏我们的真实IP地址并将请求转发给目标网站。这样,我们就可以绕过一些限制并提高数据收集的效率。

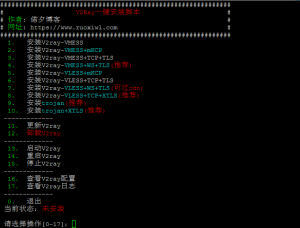

那么,如何使用爬虫代理服务器呢?以下是一些简单的步骤:

1.选择可靠的代理供应商。在选择代理供应商时,我们需要考虑其可靠性、速度和稳定性。我们可以通过查看用户评价和进行测试来评估代理供应商的性能。p

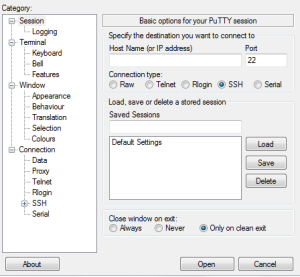

2.获取代理服务器IP地址和端口号。代理供应商将提供一份代理服务器的IP地址和端口号列表。我们需要将这些信息保存下来,以便在编写爬虫程序时使用。p

3.设置代理服务器。在编写爬虫程序时,我们需要在发送HTTP请求之前设置代理服务器。具体的设置方法可能因编程语言而异,但基本思路是将代理服务器的IP地址和端口号作为参数传递给HTTP请求函数。

4.测试代理服务器。在使用代理服务器之前,我们应该进行一些测试来确保其正常工作。我们可以编写一个简单的爬虫程序,利用代理服务器访问一些公开可用的网站,并检查返回的响应是否符合预期。

5.使用多个代理服务器。为了进一步提高数据收集效率,我们可以使用多个代理服务器。在编写爬虫程序时,我们可以将代理服务器的IP地址和端口号列表打乱,然后依次使用不同的代理服务器发送请求。这样可以减少对单个代理服务器的负载,提高整体的数据收集速度。p

尽管使用爬虫代理服务器可以提高数据收集效率,但我们仍需要遵守一些道德和法律规范。我们应该尊重网站的隐私政策和使用条款,并确保我们的爬虫活动不会对目标网站造成过大的负担。此外,我们也要注意避免爬取敏感信息或侵犯他人的权利。

总之,使用爬虫代理服务器可以帮助我们绕过一些限制并提高数据收集效率。通过选择可靠的代理供应商、设置代理服务器、进行测试和使用多个代理服务器,我们可以更好地应对互联网上的反爬虫措施,顺利地获取所需的信息。

暂无评论内容